Algorithmische Entscheidungssysteme werden zunehmend Teil unseres Lebens und damit auch der Demokratie. Die moralischen Fragen, die sie aufwerfen, gehen die ganze Gesellschaft etwas an.

Text: Sarah Kleiner

Wenn Maschinen Diskriminierung lernen

Do 14. Juli 2022

Der 12. August 2013 ist ein sonniger Tag in der Kleinstadt La Crosse im US-amerikanischen Bundesstaat Wisconsin. An diesem Tag wird der 31-jährige, bereits vorbestrafte Eric Loomis zu elf Jahren Haft verurteilt, sechs davon muss er absitzen. Loomis hatte einen Wagen gelenkt, aus dem Schüsse abgefeuert wurden. Er gestand, das Auto ohne Einverständnis des Besitzers gefahren zu haben und vor der Polizei geflüchtet zu sein. Das Urteil, das an diesem Tag über ihn verhängt wird, baut aber nicht nur auf seinen Taten auf. Es bezieht die mögliche Zukunft in das Strafmaß mit ein: Die Risk Assessment Software „Compas“ – eine Künstliche Intelligenz – hatte errechnet, dass Loomis ein hohes Risiko habe, in Zukunft wieder straffällig zu werden.

Bekannt wurde „Compas“ daraufhin nicht nur, weil Loomis und sein Anwalt gegen den Staat Wisconsin vor Gericht zogen. Sie argumentierten – allerdings erfolglos –, dass es Loomis nicht möglich sei, nachzuvollziehen, wie seine Bewertung zustande gekommen sei. Das System lieferte basierend auf einem Fragebogen und persönlichen Daten einen Score von eins bis zehn, aber die dahinterliegende Berechnung konnte nicht eingesehen werden. 2016 kam eine Analyse der investigativen Plattform ProPublica außerdem zu dem Ergebnis, dass schwarzen Menschen von der Software, die bereits in zahlreichen US-Bundesstaaten in der Justiz zum Einsatz kommt, ein fast doppelt so hohes Risiko unterstellt wurde, eine Gefahr für die Gesellschaft zu sein, wie weißen Menschen – ein eindeutiger Bias, also Überhang zu einer bestimmten Datengruppe. Aber wie kann eine Maschine zu diskriminierenden Ergebnissen kommen?

Wie gefährlich wird dieser Mann in Zukunft sein? Eric Loomis zog gegen die Berechnung seiner kriminellen Rückfallquote durch eine KI vor Gericht.

© Wisconsin Department of Correction

Künstliche Intelligenz ist mittlerweile schon viel weiter in unsere Demokratien vorgedrungen, als das vielen bewusst ist. Die Londoner Polizei setzt sowohl Echtzeit- als auch retrospektive Gesichtserkennungstechnologie ein, die auf Videoaufzeichnungen aus der Vergangenheit zurückgreift. Flughäfen, Grenzbehörden, Geheimdienste nutzen Gesichtserkennungssoftware, auch die österreichische Polizei arbeitet seit dem Jahr 2020 damit. Gebäude werden mittels KI energieeffizienter gemacht, selbstfahrende Autos und Busse sind keine Ausgeburt eines Science-Fiction-Films mehr. Je mehr sich die KI auch in Europa ausbreitet, desto drängender werden moralische und technologische Fragen, allen vorweg die Frage der Qualität der Ergebnisse, die algorithmische Entscheidungssysteme hervorbringen.

Grundlage für diese Ergebnisse sind die Daten, mit denen das System trainiert wurde. Diese Trainingsdaten werden von der KI maschinell analysiert, Muster werden erkannt und diese werden erlernt und repliziert. Speist man eine solche KI zum Beispiel mit Daten aus den Justizsystemen der Vergangenheit, in der schwarze Menschen längere oder häufiger Haftstrafen erhalten haben als weiße Menschen, dann wird die KI dieses Muster lernen. Das heißt, eine diskriminierende KI ist oftmals ein Spiegel einer diskriminierenden Gesellschaft, deren Vorurteile und Benachteiligungen in der Unzahl an Daten, die wir tagtäglich produzieren, festgehalten werden.

In der Ausstellung zu Künstlicher Intelligenz im Technischen Museum Wien wird in dem Zusammenhang eine bekannte Forschungsarbeit präsentiert. Beim Projekt „Gender Shades“ des MIT Media Lab wurden drei Gesichtserkennungsdienste von IBM, Microsoft und Face++ untersucht. Das Ergebnis: Frauen wurden von der Software seltener erkannt als Männer. Die Fehlerquote erhöhte sich noch einmal drastisch bei Menschen mit dunklerer Hautfarbe.

Diskriminierende Ergebnisse einer KI können in einer digitalisierten Welt weitreichende Konsequenzen haben. Sie können sich nicht nur auf die Entsperrung eines Smartphones via Face ID auswirken, man kann ins Kreuzfeuer der Polizei geraten, wenn eine unzulänglich trainierte Gesichtserkennungstechnologie das Ergebnis liefert, dass man einem Straftäter ähnlich sieht, nach dem gerade gefahndet wird. Große internationale Konzerne laden Bewerberinnen und Bewerber für eine freie Stelle auf Basis der Entscheidungen einer KI zu Gesprächen ein – auch hier wurden bereits diskriminierende Muster berichtet. Nicht zuletzt kann der Einsatz von diskriminierender KI in der Medizin zu falscher Diagnostik oder Therapie und allen inkludierten Folgen führen.

Sehr anschaulich setzt sich die ZDF-Doku „Programmierte Ungerechtigkeit“ mit den diskriminierenden Meta-Algorithmen von Facebook und Instagram auseinander, die Hate Speech und klassische Schönheitsideale pushen.

Link: Die Dokumentation "Programmierte Ungerechtigkeit" von Edith Löhle und Lena Nagel in der ZDF-Mediathek.

Link: Die Dokumentation "Programmierte Ungerechtigkeit" von Edith Löhle und Lena Nagel in der ZDF-Mediathek.

Ganz prinzipiell würde die KI ja das Potenzial bieten, es „besser“ zu machen als der Mensch. Denn was die KI nicht kennt, ist der Einzelfall, die Individualität. Eine KI ist nicht in der Lage, emotionale Entscheidungen zu treffen, die aus dem Raster fallen. Ein Auge zudrücken, Gnade vor Recht walten lassen, in dem Sinn positive Diskriminierung – alles nicht möglich, wenn Ergebnisse mathematisch und statistisch starr zustande kommen. Was die Maschine auch nicht kennt, ist eine auf persönlichen Erlebnissen und Vorurteilen aufbauende negative Diskriminierung. Genau diese Eigenschaften machen sie attraktiv fürs Justizsystem. Bereinigt man die Datensätze vollständig vom menschlichen Bias, so würde eine Künstliche Intelligenz auch faire Ergebnisse hervorbringen. Im Justizsystem wird sie aus diesem Grund als objektive, urteilsfreie Entscheidungshilfe angepriesen, allein in der Realität ist die Technologie offenbar noch nicht so weit.

Mit pragmatischem Blick darauf, dass sich der Einsatz dieser Technologien in unserem Alltag kaum mehr verhindern lässt, sollte sich die Gesellschaft den Fragen widmen: Wie können wir die Ergebnisse kontrollieren? Wie schaffen wir es, in diesem von Privatunternehmen und Firmengeheimnissen geprägten Sektor für Transparenz zu sorgen? Und in welchen Bereichen wollen wir KI einsetzen und wo nicht?

Aktuell besteht sogar eine dringende Notwendigkeit für die Bevölkerung, sich mit diesen Fragen auseinanderzusetzen. Auf EU-Ebene wird mit der Debatte um den „AI Act“ – einem KI-Gesetz – derzeit entschieden, wie die Staatengemeinschaft mit Algorithmen und KI umgehen wird. In Kraft treten könnte er 2023. Die österreichische NGO Epicenter Works kritisierte einen früheren Gesetzesentwurf scharf und mahnte gemeinsam mit mehr als 100 anderen zivilgesellschaftlichen Organisationen die Wahrung der Grundrechte bei der Gesetzesinitiative ein. Gefordert wird zum Beispiel Transparenz und ein Verbot von KI-Systemen, die ein „unannehmbares Risiko für die Grundrechte“ darstellen wie im Bereich Migration, oder von Social-Scoring-Systemen.

Ein Vorschlag, der im Zusammenhang mit Datenqualität öfter genannt wird, sind sozusagen TÜVs der eingesetzten KI-Technologien. Kredite vergebende Bankunternehmen, Justizsysteme, Geheimdienste, die KI nutzen, sollten auch regelmäßig überprüfen lassen, ob ihre Technologien faire Ergebnisse ohne Bias liefern, eine regelmäßige Wartung durchführen lassen also. Eine Maßnahme, um für demokratische Handhabe zu sorgen, wäre die Errichtung einer europäischen KI-Aufsichtsbehörde oder die Befugnis für nationale Datenschutzbehörden, die eingesetzten Entscheidungssysteme zu überprüfen.

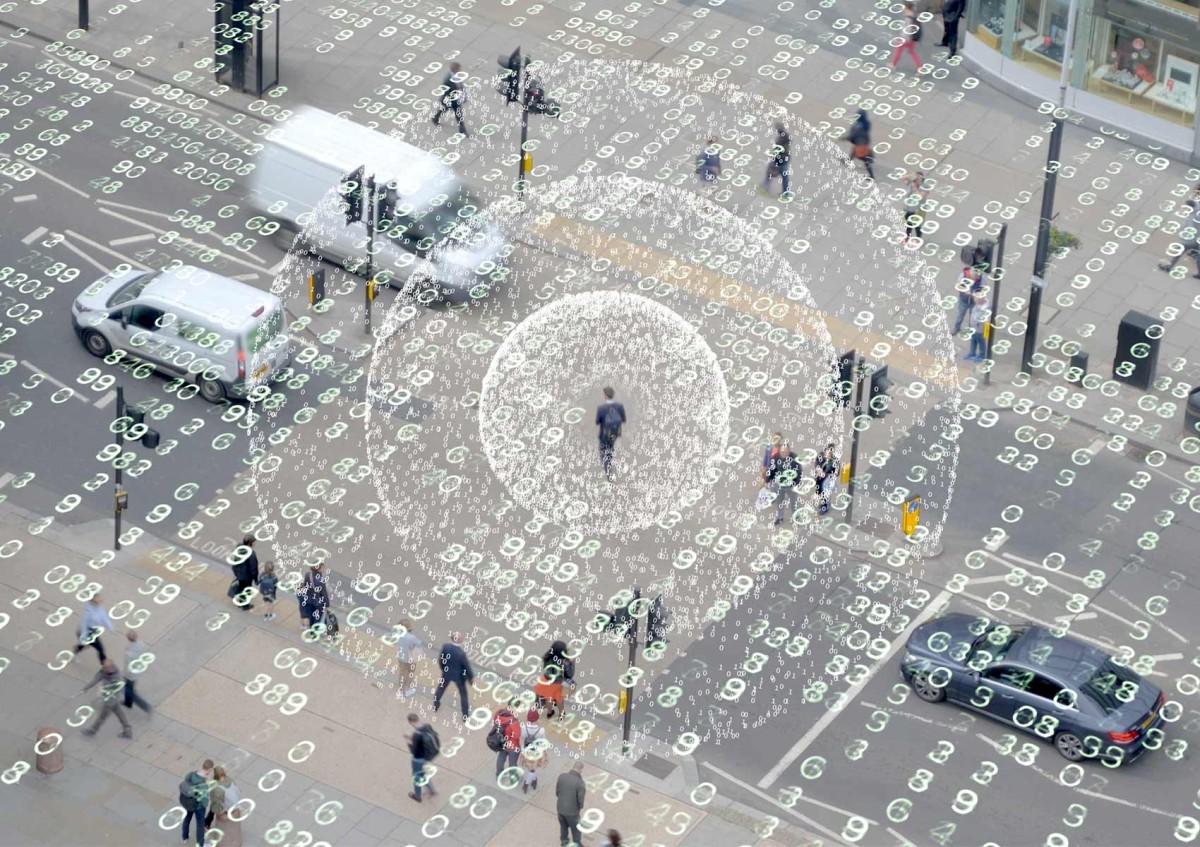

Die Angst und Bedrohung, mit der viele Menschen Künstliche Intelligenz verbinden, hängt vor allem mit ihrem Potenzial für einen Überwachungsstaat zusammen

© iStock

Auf jeden Fall setzt die Nutzung von KI im Einklang mit demokratiepolitischen Regeln eine Bevölkerung voraus, die informiert ist. Das Kennenlernen der Technologie, die hinter Künstlicher Intelligenz steckt, macht einerseits deutlich, dass sie nicht tatsächlich intelligent ist. Es handelt sich um starre, fast schon banale Entscheidungssysteme, vergleicht man sie mit der beeindruckenden Vielseitigkeit und moralischen Wendigkeit des Menschen. Andererseits wird dem Einzelnen bei der Auseinandersetzung mit KI klar, dass es hier einer demokratischen Einmischung bedarf. Die Gesellschaft muss entscheiden, wie die Welt von morgen aufgebaut ist und wer – oder was – darin über Recht und Unrecht entscheidet.

Literaturtipp:

Kristian Kersting, Christoph Lampert, Constantin Rothkopf (Hg.): Wie Maschinen lernen. Künstliche Intelligenz verständlich erklärt. Wiesbaden 2019.

Sarah Kleiner arbeitet als freie Journalistin in Wien.