Eine spektakuläre Fassadenprojektion lässt das Museumsgebäude abends erstrahlen. Wer es noch nicht live erlebt hat, gewinnt hier mithilfe eines Videos erste Eindrücke und erfährt im Interview mit dem Projektionskünstler, welche technischen Spitzfindigkeiten in der Medienfassade enthalten sind.

Eine Rakete hebt eindrucksvoll vom Technischen Museum Wien in die Erdumlaufbahn ab und die Säulen des historischen Gebäudes werden zu überdimensionalen Batterien, die sich über Solar-Paneele aufladen. Algorithmen generieren in Echtzeit Muster, die die Struktur von naturwissenschaftlichen Phänomenen nachbilden. Animationen, die von Künstlicher Intelligenz speziell für das Museumsgebäude kreiert wurden. Die neue Fassadenprojektion des Museums ist mehr als bloße Behübschung, sondern bringt die technisch-naturwissenschaftlichen Inhalte und Werte des Hauses auch nach draußen.

Der auf 3D-Projection-Mapping spezialisierte 3D-Künstler Lucas Dikany, der neben der Projektleitung auch die künstlerische Konzeption, Content-Produktion und technische Umsetzung verantwortete, erzählt im Interview, welche innovativen Technologien dafür verwendet wurden und welche technischen Spitzfindigkeiten dahinterstecken.

Ab Einbruch der Dunkelheit dienen nun 720 m2 der Museumsfassade als Leinwand für ein kunstvolles 3D-Projection-Mapping von museumsspezifischen Themen. Ein beeindruckendes Spektakel mit phantastischen Effekten. Was steckt dahinter und was bedeutet 3D-Projection-Mapping eigentlich?

3D-Projection-Mapping ist eine Projektion auf eine irreguläre Oberfläche, bei der die Projektion derart angepasst wird, dass Zuschauerinnen und Zuschauer einen illusorischen Effekt erleben. Dieser illusorische Effekt entsteht aber nicht durch die Animation der projizierten Inhalte alleine, sondern erst in Verbindung mit dem 3D-Körper, der angestrahlt wird. Am Screen „funktioniert“ die Animation schon, aber die gewünschte Illusion kommt erst auf der Fassade richtig zur Geltung. Das liegt natürlich auch daran, dass das Erlebnis in der Realität noch einmal beeindruckender ist – nicht zuletzt auch wegen der Größe.

Um diesen illusorischen Effekt zu kreieren, müssen also Projektion und „Leinwand“ also perfekt aufeinander abgestimmt sein. Wie habt ihr das bewerkstelligt?

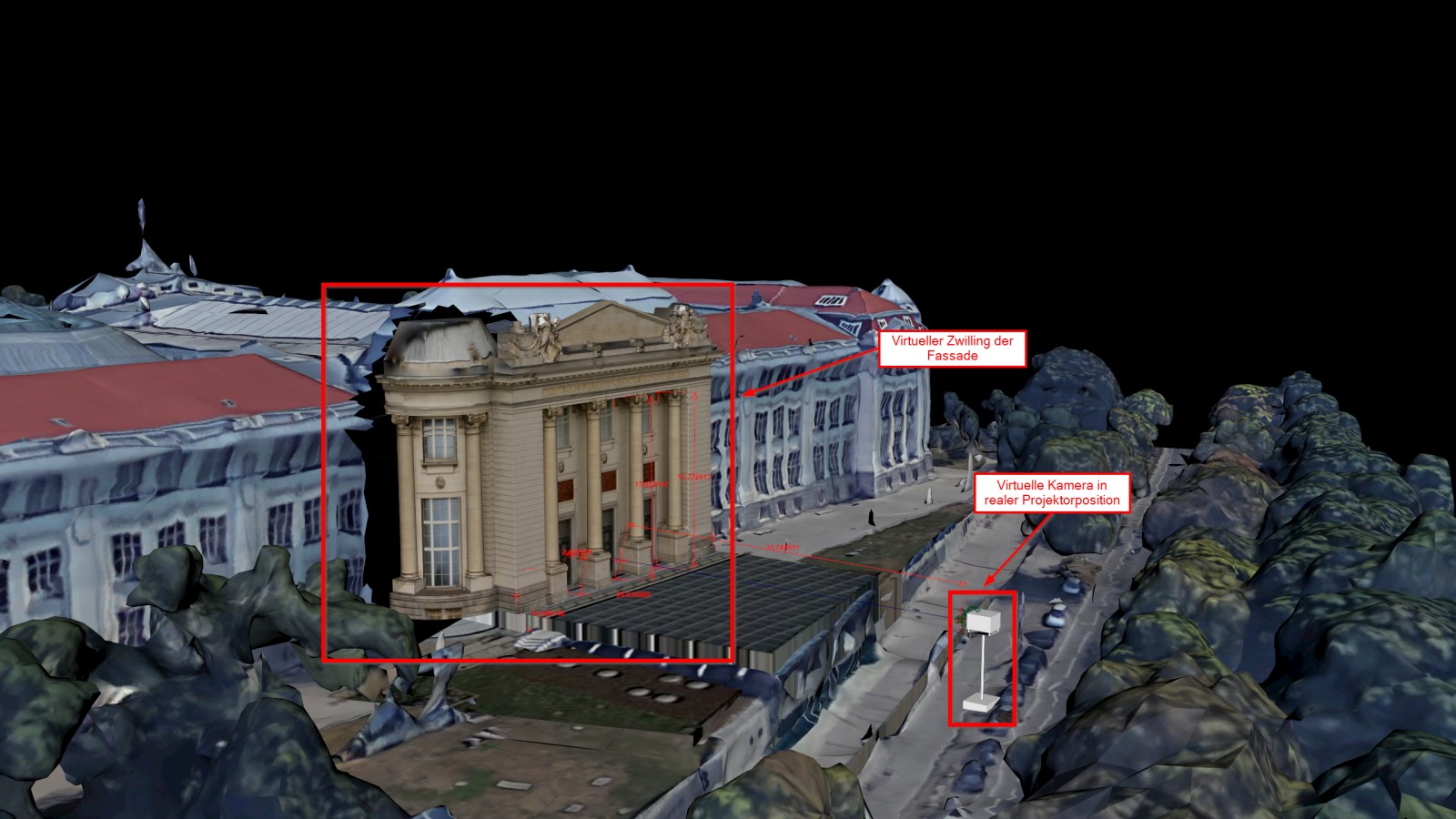

Zuerst braucht man einen virtuellen Zwilling vom angestrahlten 3D-Körper – in diesem Fall von der Südfassade des Technischen Museums. Dabei bildet man die realen Gegebenheiten digital nach, startend mit der 3D-Geometrie des Gebäudes in Relation zu dem Punkt, wo der Projektor stehen wird. Noch detaillierter wird es beim sogenannten Texturing, wo auch die Oberfläche der Fassade erfasst wird – Strukturen, Ornamente, Farben – also auch Dinge, die nicht dreidimensional sind, sondern zum Beispiel nur aufgemalt. Wir haben das mit Fotogammetrie gemacht, das heißt wir haben 300 Fotos von allen möglichen Winkeln der Fassade geschossen und die Fotos dann in einen Algorithmus eingespeist, der daraus ein digitales 3D-Modell erstellt.

Aber man braucht nicht nur einen virtuellen Zwilling der Fassade, sondern auch vom Projektor. Digital ist das dann eine Kamera, deren Linse ähnlichen Eigenschaften wie der reale Projektor hat. Dann kalibriere ich Kamera und 3D-Modell exakt so wie Projektor und Museum zueinanderstehen und so hat man als ersten Schritt die realen Gegebenheiten virtuell nachgebildet. Als zweiter Schritt wurde die digitale Fassade modular zerlegt, damit man sie einzeln manipulieren kann – zum Beispiel nur die Säulen drehen. Und dann geht’s schon an die Animation.

Was gibt es bei der Animation von einer 3D-Projektion besonderes zu bedenken?

Vieles, was am Screen funktioniert, funktioniert bei einer Projektion nicht. Als wichtigstes Beispiel: Man kann kein Schwarz projizieren, denn Schwarz ist einfach kein Licht. Außerdem muss man beim Animieren natürlich auf den Rahmen eingehen, den die Fassade gibt. Die Projektion jenseits der Fassade ist nicht sichtbar und Farben, Vorsprünge oder Strukturen des Gebäudes beeinflussen, wie die Projektion aussieht. Deswegen haben wir ja den virtuellen Zwilling gemacht, aber wirklich sehen, ob der illusorische Effekt gelingt, kann man erst bei der realen Projektion.

Bei den Fassadenprojektion des Museums mussten wir natürlich auch die anliegende Straße bedenken. Wir haben also mit weniger Geschwindigkeit und weniger Kontrast gearbeitet. Außerdem haben wir die Effekte auch flächiger konzipiert, das macht das Ganze auch ruhiger. Um trotzdem denselben Wow-Effekt zu kreieren, haben wir allgemein mehr szenisch als flashig gearbeitet.

Zusätzlich schwingt in der Gestaltung der Animationen auch eine technisch-naturwissenschaftliche Meta-Ebene mit. Kannst du uns mehr davon erzählen?

Wir haben zum Beispiel Animationen erstellt, die den Systematiken von naturwissenschaftlichen Phänomenen folgen. Ein chemischer oder biologischer Prozess, der algorithmisch abbildbar ist, wird also digital mit visuellem Output reproduziert. Diese Sequenzen werden auch in Echtzeit prozedural vom definierten Algorithmus generiert. Die zusätzliche Besonderheit ist, dass wir das Regelwerk, nach dem der Algorithmus arbeitet, bei jedem Durchgang geringfügig verändern können. Dadurch variieren Geschwindigkeiten, Texturen oder Farben und jeder dieser Sequenzen ist ein im Moment erstelltes Unikat.

Außerdem werden auch Inhalte projiziert, die von Künstlicher Intelligenz erzeugt wurden. Für diese sogenannten Style Transfers nehmen wir ein Foto von der Museumsfassade und ein Foto von einem künstlerischen Werk und speisen die beiden in eine Künstliche Intelligenz ein, die dann den Stil des Kunstwerks mit der Optik der Fassade vermischt. Dadurch können wir die Museumsfassade in speziell angepasste Kunstwerke tauchen, ohne dass wir das sehr aufwendig per Hand designen müssen. Die Künstliche Intelligenz macht das in wenigen Minuten – allerdings muss man sie dafür auch aufwendig trainieren und viele Iterationen durchlaufen, um den gewünschten Look zu treffen.

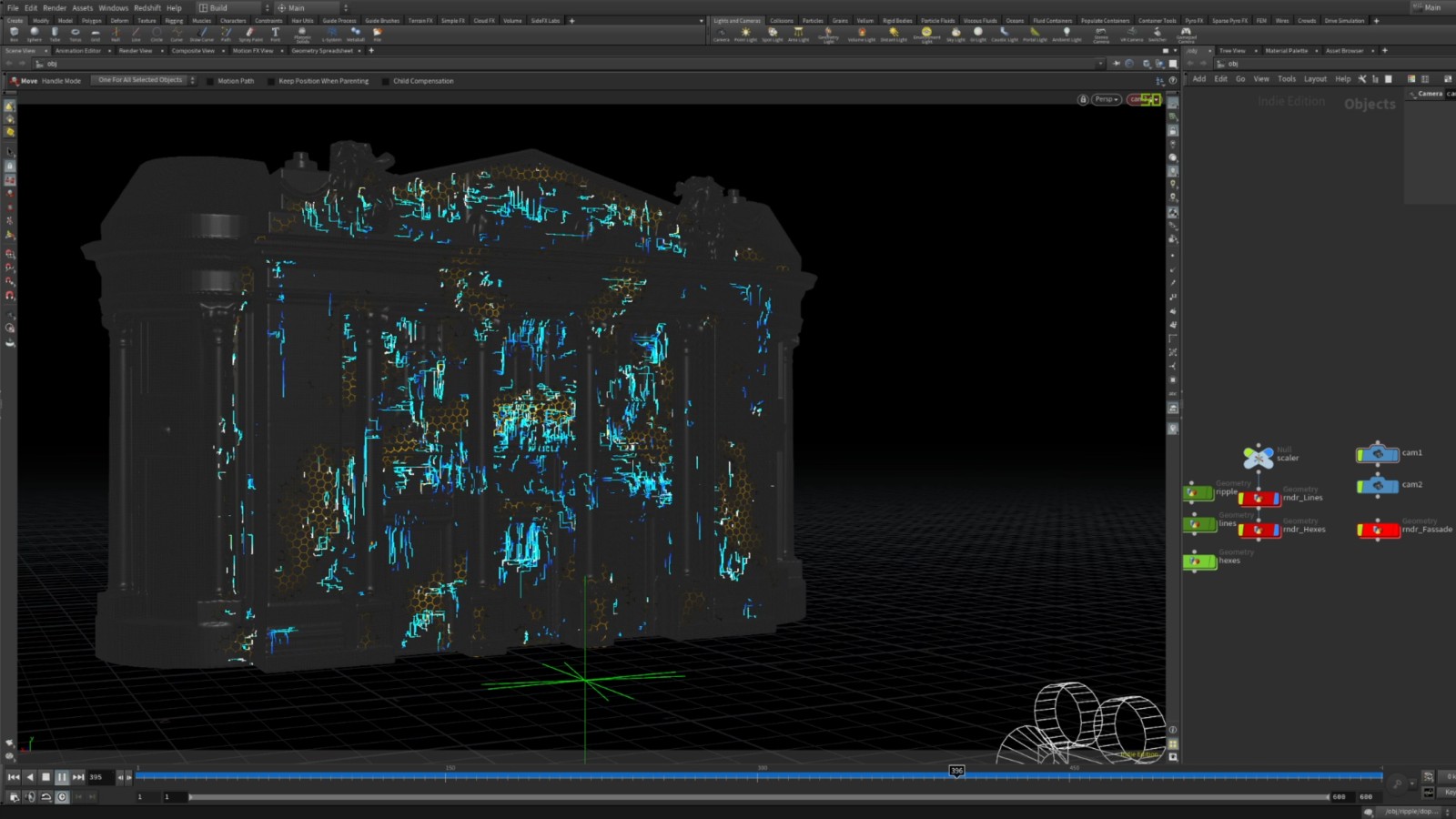

Stichwort Software: An die 15 unterschiedlichen Programme kamen für diese Projektion zum Einsatz. Welche speziellen Programme und Softwares braucht man für eine 3D-Projektion?

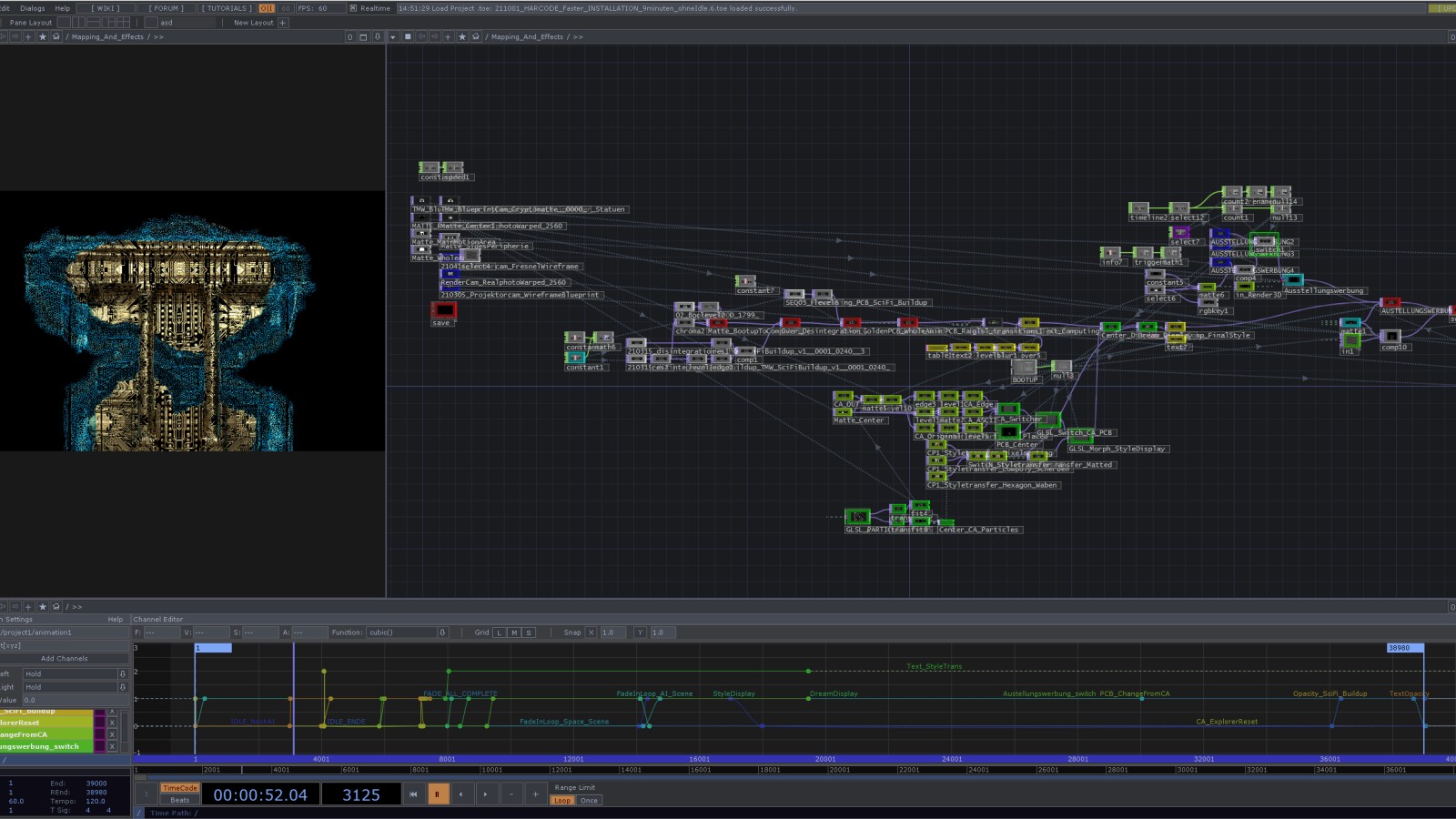

Ja, tatsächlich haben wir zwischen 12 und 15 Softwarepakete genutzt, darunter unterschiedlichste Rendering-Programme, 3D-Modelling-Programme, 3D- und 2D-Animationsprogramme, aber auch Klassiker wie Photoshop oder Illustrator. Und auch ganz abstruse Softwarepakete wie zum Beispiel eines, das eigentlich dafür genutzt wird, reale Leiterplatten zu entwerfen, die in der Sequenz zur Sonderausstellung „Künstliche Intelligenz?“ zu sehen sind. Aber das Herzstück der gesamten Projektion ist TouchDesigner. Das Programm steuert die Abfolge aller Videos, Bilder, 2D- und 3D-Animationen, den Output, der an den Projektor gesendet wird, und auch den Projektor selbst. Und reagiert dabei sogar auf die Umgebung: Im Winter, wenn es früher dunkel wird, startet der Projektor also auch „selbstständig“ früher. Das wirklich Besondere an TouchDesigner ist aber, dass das Programm auch in Echtzeit Inhalte generieren kann – wie die zuvor erwähnten Systematiken von naturwissenschaftlichen Phänomenen – und diese in die Projektion integriert.

Die Projektion erstellt sich also selbst?

Das dahinterliegende Programm erzeugt die Animationen auf Basis der eingespeisten Daten und der programmierten Regeln. Das gibt es noch weitere Möglichkeiten, zum Beispiel kann man Echtzeiten verwenden, die dann visuell dargestellt werden. Das ist auch als zukünftige Erweiterung bei der Projektion am Technischen Museum geplant, dass Informationen von öffentlichen Datenbanken wie Wetterdaten zur aktuellen Luftqualität oder Erdbeobachtungsdaten von Satelliten der ESA in die Projektion eingespeist werden. Die eingespeisten Daten können aber auch von Sensoren kommen, die am Museum angebracht sind. So können Animationen abhängig von Windstärke und/oder Windrichtung gesteuert werden.

Auch in der Content-Produktion habt ihr innovative Technologien genutzt?

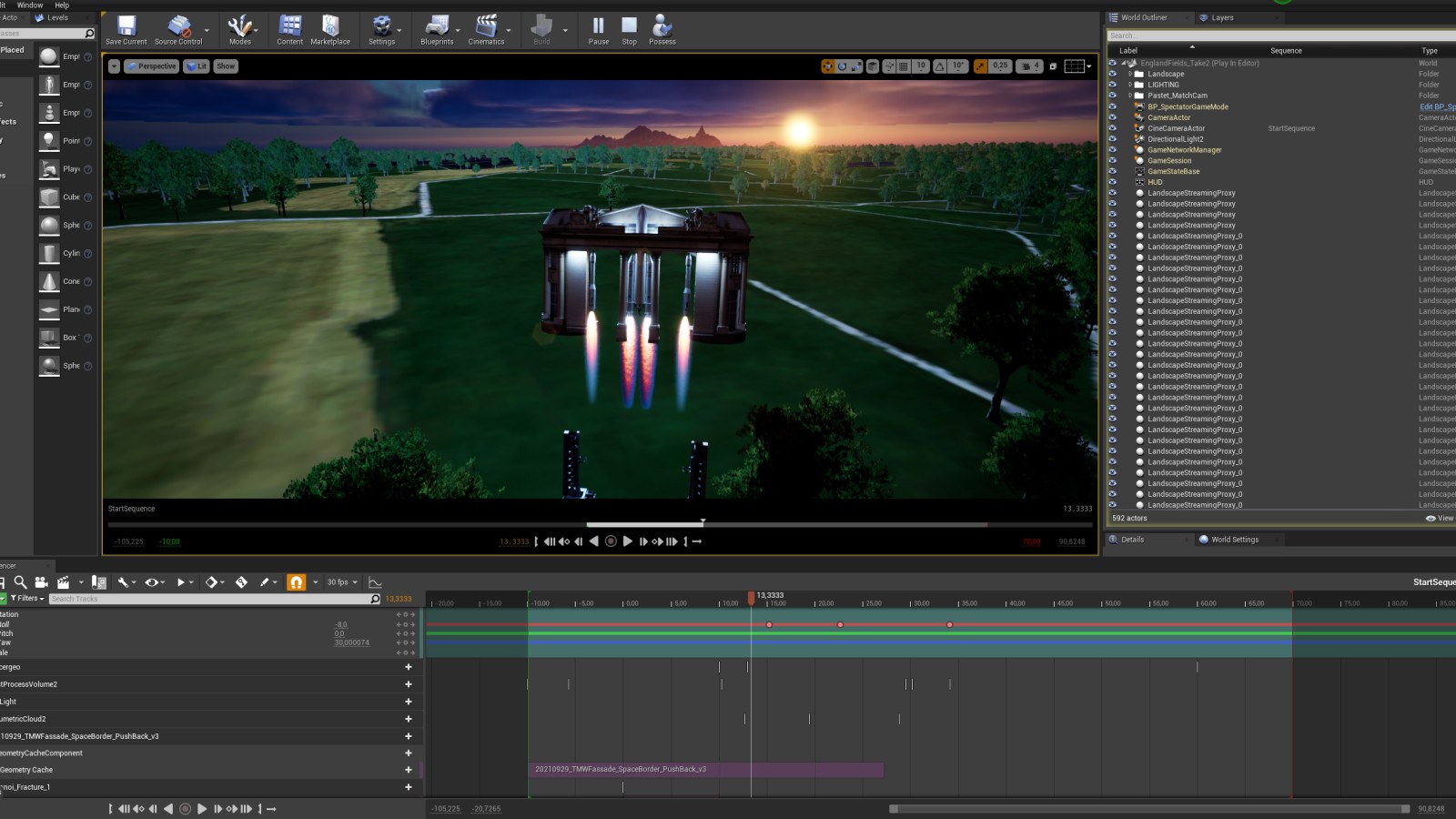

Ja, die Szene zum Thema Raumfahrt haben wir zum Beispiel in einer Spieleentwicklungsumgebung erstellt. Das hat den immensen Vorteil, dass Renderzeiten de facto wegfallen. Denn bei so einem speziellen 3D-Content in dieser Qualität muss eine einminütige Animation bis zu 200 Stunden rendern – also da ist wirklich nur die Hardware damit beschäftigt die Einzelbilder zu errechnen.

Bei der Raumfahrts-Sequenz haben wir die Spieleentwicklungsumgebung Unreal Engine von Epic Games genutzt. Die dreiminütige Sequenz braucht so nur mehr drei Minuten zum Rendern – und nicht wie sonst drei Minuten pro Frame. Das macht bei 5400 Frames natürlich einen gewaltigen Unterschied, der für uns ein Game Changer war.

Eine sehr breit gefächerte und komplexe technische und kreative Tätigkeit. Was fasziniert dich persönlich daran und welche Fertigkeiten musstest du dir dafür aneignen?

Für mich ist das Spannende beim 3D-Projection-Mapping, dass ich nicht nur am Screen arbeite, sondern, dass ich das, was ich mache, auch in die „Realität“ bringe, weil ich es auf ein reales Objekt projiziere. Dadurch wird es, finde ich, greifbarer und erlebbarer. Außerdem kenne ich keinen anderen Bereich, in dem so viele unterschiedliche Aspekte der digitalen Medienerstellung fusionieren wie in dieser speziellen Projektionskunst. Neben den grafischen und künstlerischen Fähigkeiten, die man braucht, um den Content der Projektion zu erstellen, benötigt man auch Fertigkeiten in Architektur-Visualisierung und 3D-Modelling. Auch mein Medientechnik-Studium fließt ein, denn für 3D-Projection-Mapping braucht man ebenso ein Verständnis von der Hardware und muss wissen, wie man den Projektor richtig „anspricht“. Fotografie und Kinematografie sind ein weiterer Teil. Und bei der Integration von in Echtzeit generierten Inhalten ist auch Programmieren gefragt. Mit der Projektionskunst kann ich alle diese Interessensbereiche vereinen und all das Tüfteln mit den unterschiedlichsten Programmen macht einfach Spaß.

Die Leidenschaft ist auch in der Projektion sichtbar. Danke für das Gespräch.

Der auf 3D-Projection-Mapping spezialisierte 3D-Künstler Lucas Dikany, der neben der Projektleitung auch die künstlerische Konzeption, Content-Produktion und technische Umsetzung verantwortete, erzählt im Interview, welche innovativen Technologien dafür verwendet wurden und welche technischen Spitzfindigkeiten dahinterstecken.

Ab Einbruch der Dunkelheit dienen nun 720 m2 der Museumsfassade als Leinwand für ein kunstvolles 3D-Projection-Mapping von museumsspezifischen Themen. Ein beeindruckendes Spektakel mit phantastischen Effekten. Was steckt dahinter und was bedeutet 3D-Projection-Mapping eigentlich?

3D-Projection-Mapping ist eine Projektion auf eine irreguläre Oberfläche, bei der die Projektion derart angepasst wird, dass Zuschauerinnen und Zuschauer einen illusorischen Effekt erleben. Dieser illusorische Effekt entsteht aber nicht durch die Animation der projizierten Inhalte alleine, sondern erst in Verbindung mit dem 3D-Körper, der angestrahlt wird. Am Screen „funktioniert“ die Animation schon, aber die gewünschte Illusion kommt erst auf der Fassade richtig zur Geltung. Das liegt natürlich auch daran, dass das Erlebnis in der Realität noch einmal beeindruckender ist – nicht zuletzt auch wegen der Größe.

Um diesen illusorischen Effekt zu kreieren, müssen also Projektion und „Leinwand“ also perfekt aufeinander abgestimmt sein. Wie habt ihr das bewerkstelligt?

Zuerst braucht man einen virtuellen Zwilling vom angestrahlten 3D-Körper – in diesem Fall von der Südfassade des Technischen Museums. Dabei bildet man die realen Gegebenheiten digital nach, startend mit der 3D-Geometrie des Gebäudes in Relation zu dem Punkt, wo der Projektor stehen wird. Noch detaillierter wird es beim sogenannten Texturing, wo auch die Oberfläche der Fassade erfasst wird – Strukturen, Ornamente, Farben – also auch Dinge, die nicht dreidimensional sind, sondern zum Beispiel nur aufgemalt. Wir haben das mit Fotogammetrie gemacht, das heißt wir haben 300 Fotos von allen möglichen Winkeln der Fassade geschossen und die Fotos dann in einen Algorithmus eingespeist, der daraus ein digitales 3D-Modell erstellt.

Aber man braucht nicht nur einen virtuellen Zwilling der Fassade, sondern auch vom Projektor. Digital ist das dann eine Kamera, deren Linse ähnlichen Eigenschaften wie der reale Projektor hat. Dann kalibriere ich Kamera und 3D-Modell exakt so wie Projektor und Museum zueinanderstehen und so hat man als ersten Schritt die realen Gegebenheiten virtuell nachgebildet. Als zweiter Schritt wurde die digitale Fassade modular zerlegt, damit man sie einzeln manipulieren kann – zum Beispiel nur die Säulen drehen. Und dann geht’s schon an die Animation.

Was gibt es bei der Animation von einer 3D-Projektion besonderes zu bedenken?

Vieles, was am Screen funktioniert, funktioniert bei einer Projektion nicht. Als wichtigstes Beispiel: Man kann kein Schwarz projizieren, denn Schwarz ist einfach kein Licht. Außerdem muss man beim Animieren natürlich auf den Rahmen eingehen, den die Fassade gibt. Die Projektion jenseits der Fassade ist nicht sichtbar und Farben, Vorsprünge oder Strukturen des Gebäudes beeinflussen, wie die Projektion aussieht. Deswegen haben wir ja den virtuellen Zwilling gemacht, aber wirklich sehen, ob der illusorische Effekt gelingt, kann man erst bei der realen Projektion.

Bei den Fassadenprojektion des Museums mussten wir natürlich auch die anliegende Straße bedenken. Wir haben also mit weniger Geschwindigkeit und weniger Kontrast gearbeitet. Außerdem haben wir die Effekte auch flächiger konzipiert, das macht das Ganze auch ruhiger. Um trotzdem denselben Wow-Effekt zu kreieren, haben wir allgemein mehr szenisch als flashig gearbeitet.

Zusätzlich schwingt in der Gestaltung der Animationen auch eine technisch-naturwissenschaftliche Meta-Ebene mit. Kannst du uns mehr davon erzählen?

Wir haben zum Beispiel Animationen erstellt, die den Systematiken von naturwissenschaftlichen Phänomenen folgen. Ein chemischer oder biologischer Prozess, der algorithmisch abbildbar ist, wird also digital mit visuellem Output reproduziert. Diese Sequenzen werden auch in Echtzeit prozedural vom definierten Algorithmus generiert. Die zusätzliche Besonderheit ist, dass wir das Regelwerk, nach dem der Algorithmus arbeitet, bei jedem Durchgang geringfügig verändern können. Dadurch variieren Geschwindigkeiten, Texturen oder Farben und jeder dieser Sequenzen ist ein im Moment erstelltes Unikat.

Außerdem werden auch Inhalte projiziert, die von Künstlicher Intelligenz erzeugt wurden. Für diese sogenannten Style Transfers nehmen wir ein Foto von der Museumsfassade und ein Foto von einem künstlerischen Werk und speisen die beiden in eine Künstliche Intelligenz ein, die dann den Stil des Kunstwerks mit der Optik der Fassade vermischt. Dadurch können wir die Museumsfassade in speziell angepasste Kunstwerke tauchen, ohne dass wir das sehr aufwendig per Hand designen müssen. Die Künstliche Intelligenz macht das in wenigen Minuten – allerdings muss man sie dafür auch aufwendig trainieren und viele Iterationen durchlaufen, um den gewünschten Look zu treffen.

Stichwort Software: An die 15 unterschiedlichen Programme kamen für diese Projektion zum Einsatz. Welche speziellen Programme und Softwares braucht man für eine 3D-Projektion?

Ja, tatsächlich haben wir zwischen 12 und 15 Softwarepakete genutzt, darunter unterschiedlichste Rendering-Programme, 3D-Modelling-Programme, 3D- und 2D-Animationsprogramme, aber auch Klassiker wie Photoshop oder Illustrator. Und auch ganz abstruse Softwarepakete wie zum Beispiel eines, das eigentlich dafür genutzt wird, reale Leiterplatten zu entwerfen, die in der Sequenz zur Sonderausstellung „Künstliche Intelligenz?“ zu sehen sind. Aber das Herzstück der gesamten Projektion ist TouchDesigner. Das Programm steuert die Abfolge aller Videos, Bilder, 2D- und 3D-Animationen, den Output, der an den Projektor gesendet wird, und auch den Projektor selbst. Und reagiert dabei sogar auf die Umgebung: Im Winter, wenn es früher dunkel wird, startet der Projektor also auch „selbstständig“ früher. Das wirklich Besondere an TouchDesigner ist aber, dass das Programm auch in Echtzeit Inhalte generieren kann – wie die zuvor erwähnten Systematiken von naturwissenschaftlichen Phänomenen – und diese in die Projektion integriert.

Die Projektion erstellt sich also selbst?

Das dahinterliegende Programm erzeugt die Animationen auf Basis der eingespeisten Daten und der programmierten Regeln. Das gibt es noch weitere Möglichkeiten, zum Beispiel kann man Echtzeiten verwenden, die dann visuell dargestellt werden. Das ist auch als zukünftige Erweiterung bei der Projektion am Technischen Museum geplant, dass Informationen von öffentlichen Datenbanken wie Wetterdaten zur aktuellen Luftqualität oder Erdbeobachtungsdaten von Satelliten der ESA in die Projektion eingespeist werden. Die eingespeisten Daten können aber auch von Sensoren kommen, die am Museum angebracht sind. So können Animationen abhängig von Windstärke und/oder Windrichtung gesteuert werden.

Auch in der Content-Produktion habt ihr innovative Technologien genutzt?

Ja, die Szene zum Thema Raumfahrt haben wir zum Beispiel in einer Spieleentwicklungsumgebung erstellt. Das hat den immensen Vorteil, dass Renderzeiten de facto wegfallen. Denn bei so einem speziellen 3D-Content in dieser Qualität muss eine einminütige Animation bis zu 200 Stunden rendern – also da ist wirklich nur die Hardware damit beschäftigt die Einzelbilder zu errechnen.

Bei der Raumfahrts-Sequenz haben wir die Spieleentwicklungsumgebung Unreal Engine von Epic Games genutzt. Die dreiminütige Sequenz braucht so nur mehr drei Minuten zum Rendern – und nicht wie sonst drei Minuten pro Frame. Das macht bei 5400 Frames natürlich einen gewaltigen Unterschied, der für uns ein Game Changer war.

Eine sehr breit gefächerte und komplexe technische und kreative Tätigkeit. Was fasziniert dich persönlich daran und welche Fertigkeiten musstest du dir dafür aneignen?

Für mich ist das Spannende beim 3D-Projection-Mapping, dass ich nicht nur am Screen arbeite, sondern, dass ich das, was ich mache, auch in die „Realität“ bringe, weil ich es auf ein reales Objekt projiziere. Dadurch wird es, finde ich, greifbarer und erlebbarer. Außerdem kenne ich keinen anderen Bereich, in dem so viele unterschiedliche Aspekte der digitalen Medienerstellung fusionieren wie in dieser speziellen Projektionskunst. Neben den grafischen und künstlerischen Fähigkeiten, die man braucht, um den Content der Projektion zu erstellen, benötigt man auch Fertigkeiten in Architektur-Visualisierung und 3D-Modelling. Auch mein Medientechnik-Studium fließt ein, denn für 3D-Projection-Mapping braucht man ebenso ein Verständnis von der Hardware und muss wissen, wie man den Projektor richtig „anspricht“. Fotografie und Kinematografie sind ein weiterer Teil. Und bei der Integration von in Echtzeit generierten Inhalten ist auch Programmieren gefragt. Mit der Projektionskunst kann ich alle diese Interessensbereiche vereinen und all das Tüfteln mit den unterschiedlichsten Programmen macht einfach Spaß.

Die Leidenschaft ist auch in der Projektion sichtbar. Danke für das Gespräch.

Für die Content-Erstellung wurden einerseits klassische 3D Special Effects Programme genutzt ...

© Lucas Dikany

Für die Content-Erstellung wurden auch innovative Spieleentwicklungsumgebungen genutzt, die praktisch keine Render-Zeiten mehr benötigen

© Lucas Dikany

Steuerungsinput in TouchDesigner im Vergleich zur tatsächlichen Projektion

© Technisches Museum Wien

Im ersten Schritt muss ein virtueller Zwilling der Fassade erstellt werden

© Technisches Museum Wien

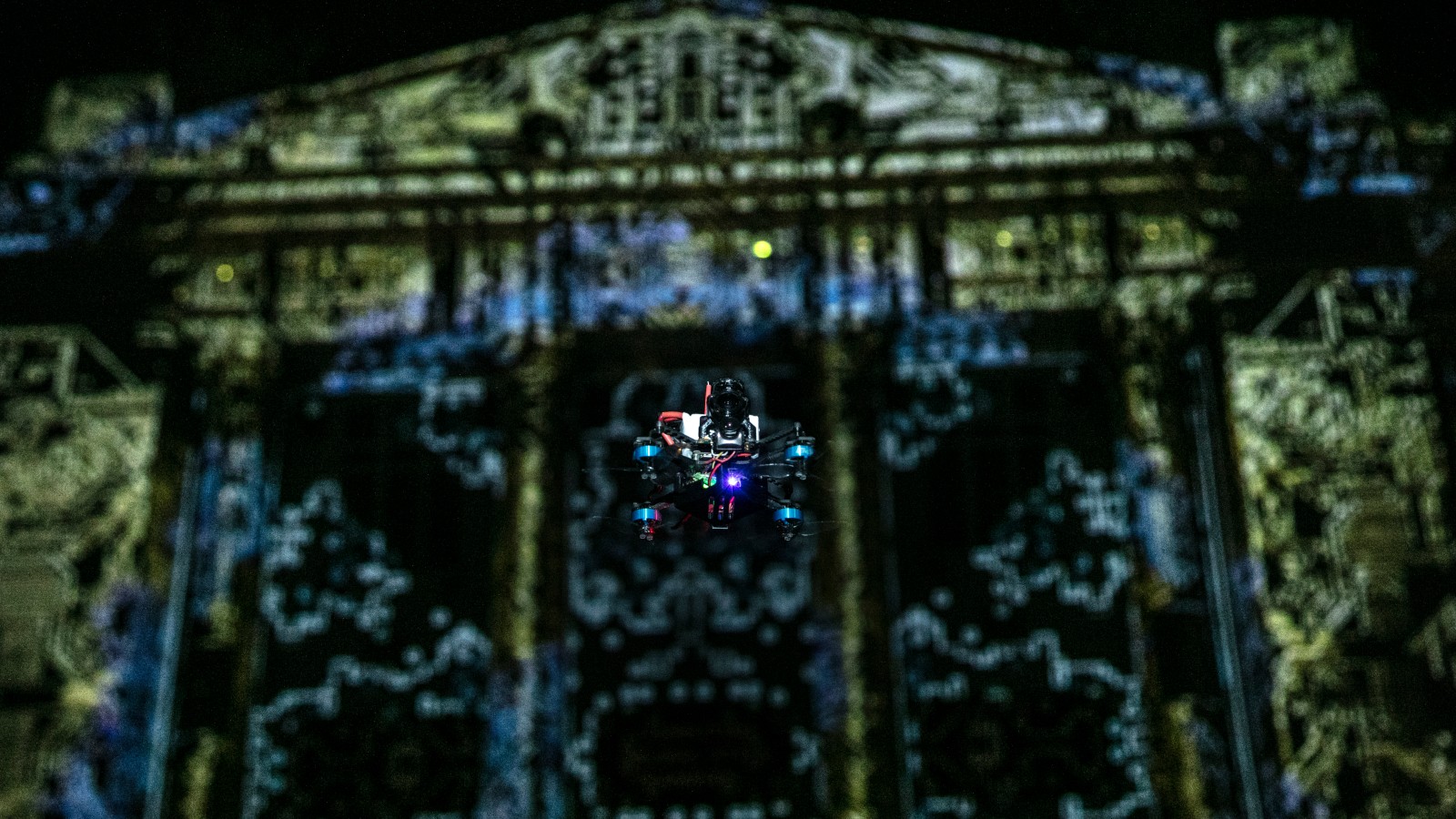

Für das Video von der Fassadenprojektion wurde auch mit einer Drohne gefilmt

© Technisches Museum Wien